Más de una vez hemos hablado de los peligros de la Inteligencia Artificial, peligros de los que alertó Geoffrey Hinton, ex Google y uno de los padrinos de esta tecnología, al abandonar La Gran G. Sin embargo, muchos creen que no somos conscientes de lo que viene; y piensan que la IA pondrá en jaque nuestro conocimiento y la ciencia toda. Hablando de eso, ¿te das una idea de cuáles son los riesgos del uso de la IA en la investigación científica?

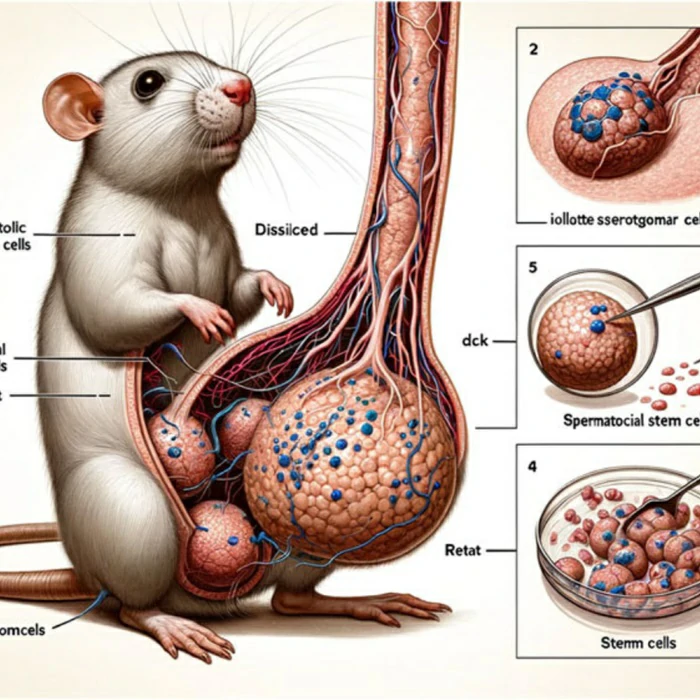

En este artículo vamos a repasar algunos de los miedos de la comunidad, esos que están siendo señalados por varios prestigiosos investigadores de todo el mundo luego de que se difundieran imágenes de ratas con genitales grotescamente grandes en las últimas semanas. ¿Cuál era el problema? Las fotos eran falsas, y generadas con IA.

Este incidente no ha hecho más que reforzar la creciente preocupación por el uso de la Inteligencia Artificial para simular investigaciones científicas, lo que podría hacer que los estudios e informes reales resulten rechazados. Aunque los peligros son inherentes a una nueva tecnología, otros plantean riesgos epistémicos potenciales.

El planteo de dos investigadoras sobre la ciencia y la IA

Una publicación reciente en la reconocida revista Nature aborda esta problemática mediante un intercambio realizado por dos profesionales del sector que asisten, con miedo, al avance de la Inteligencia Artificial en el ámbito científico.

- Molly Crockett: psicóloga de la Universidad de Princeton. Colabora en informes acerca de cómo aprendemos los seres humanos y cómo tomamos decisiones en situaciones sociales que pueden ser altamente conflictivas.

- Lisa Messeri: antropóloga de la Universidad de Yale. Se centra en la ciencia y la tecnología, profundizando respecto a cómo se desarrolla la comunidad científica a medida que surgen campos de conocimiento.

Originalmente, la publicación de Crockett y Messeri nace como una respuesta a una nota que tiene ya cinco años. Por aquel entonces, en Proceedings of the National Academy of Sciences se publicó esta nota en la que se afirma que «los investigadores podrían utilizar el aprendizaje automático para predecir la replicabilidad de los estudios basándose únicamente en un análisis de sus textos». Un lustro más tarde, ambas dudan de esa afirmación.

Esta pareja de científicas decidió hacer un análisis en profundidad en torno a cómo los científicos pueden verse más limitados que liberados por la Inteligencia Artificial. ¿Cómo afectará la IA y otras tecnologías al proceso académico?

Los riesgos de la Inteligencia Artificial en la ciencia

Para su análisis, establecieron cuatro categorías de visiones de la Inteligencia Artificial en el ámbito científico.

- Como Oracle: puede ayudar a los investigadores a buscar, leer y resumir la casi infinita literatura científica

- «sustituta»: capaz de reemplazar a los humanos, conectando datos y proporcionando información

- Quant: aprovechando los instrumentos de Big Data, superando el conocimiento de los humanos

- Como «árbitro»: capaz de evaluar la eficiencia de la investigación y la viabilidad de los marcos teóricos

Para cada una de las categorías hay ventajas y desventajas. Por supuesto, les preocupan los puntos débiles. Consideran que podría haber «ilusiones de comprensión». Es decir, que los científicos apoyados en la IA acaben interpretando que entienden más de un tema de lo que realmente entienden. Si este apoyo se vuelve dependencia será peor aún, ya que los márgenes cognitivos se podrían reducir mucho en pocas generaciones.

A su vez, dentro de las ilusiones de comprensión subclasifican algunas como las explicativas y las exploratorias. Científicos imposibilitados de explicar sus conclusiones, o explorando menos hipótesis de las existentes son dos situaciones en las que hacen hincapié Crockett y Messeri. Pero la que más temor les provoca no es una de éstas, sino la ilusión de objetividad: confiar exageradamente en que la IA es más objetiva que nosotros cuando no es así.

¿Produciremos más ciencia comprendiendo menos?

Tanto Crockett como Messeri tienden a imaginar que si la IA es adoptada por los científicos sin hacerse mayores preguntas al respecto, lo que pasará es que produciremos más ciencia -o más contenidos científicos- aún cuando comprendamos menos del universo. Se publican más artículos científicos que en ningún otro momento, pero sólo algunos valen la pena. Y esos que valen la pena podrían ser acusados de ser falsos, como la imagen de la rata.

Si bien no se oponen a su uso, las profesionales avisan de los riesgos de la IA en la investigación científica.