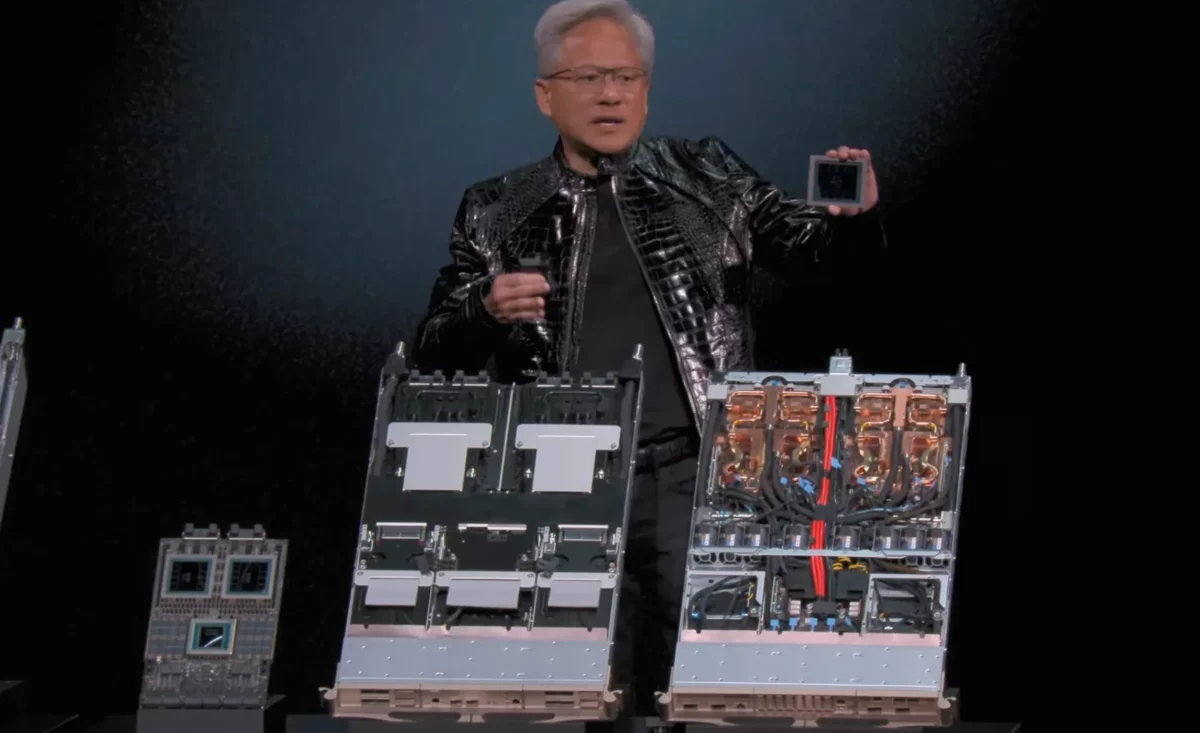

La Feria de Electrónica de Consumo (CES) de este año ha servido para que Jensen Huang, consejero delegado de Nvidia, presentara oficialmente su nueva arquitectura Vera Rubin, diseñada para suceder a la actual línea Blackwell.

Este anuncio llega en un momento donde la exigencia de cálculo para la inteligencia artificial está alcanzando cotas vertiginosas, obligando a los fabricantes a encontrar soluciones que aumenten la potencia bruta y optimicen el consumo energético.

Nvidia Vera Rubin

La arquitectura, que ya se encuentra en plena fase de fabricación, debe su nombre a la astrónoma estadounidense que aportó pruebas sobre la existencia de la materia oscura, un guiño a la intención de la empresa de iluminar las zonas inexploradas del cómputo masivo.

El corazón de esta arquitectura es la nueva GPU, pero se complementa con una CPU específica llamada Vera, pensada para tareas de razonamiento, y mejoras sustanciales en la interconexión con NVLink 6. La necesidad de este salto técnico responde a los modelos actuales sufren cuellos de botella en el almacenamiento. Para solucionarlo, han ideado un nivel de almacenamiento externo que permite escalar los grupos de trabajo con mayor fluidez.

Según sus pruebas internas, este nuevo esquema es x3,5 más rápido en el entrenamiento de modelos y quintuplica la velocidad en tareas de inferencia respecto a su predecesora, logrando todo esto con una eficiencia energética ocho veces mayor por vatio.

Amazon Web Services, Google, Microsoft y OpenAI ya han confirmado que adoptarán los chips Rubin en sus centros de datos, asegurando que la infraestructura necesaria para soportar estos avances esté lista en la segunda mitad del año. Además, supercomputadoras como Blue Lion de HPE y Doudna del Laboratorio Nacional Lawrence Berkeley serán las primeras en integrar esta tecnología para la investigación científica.

El salto al razonamiento físico y la conducción autónoma

Más allá del silicio puro, la presentación dejó claro que el objetivo es llevar la inteligencia artificial fuera de los servidores y meterla en objetos tangibles. Nvidia llama a este fenómeno el «momento ChatGPT de la IA física», donde las máquinas ya no solo procesan datos, sino que entienden y razonan sobre el entorno físico.

Aquí entra en juego Alpamayo, un conjunto de modelos de visión, lenguaje y acción que puede cambiar la forma en que los vehículos autónomos toman decisiones. La gran novedad está en que el sistema puede explicar por qué frenó o giró, aportando una capa de transparencia para la confianza del usuario.

El primer beneficiado de esta tecnología será el Mercedes-Benz CLA de nueva generación, que integrará estas capacidades de conducción asistida y llegará a las carreteras estadounidenses en el primer trimestre del año.

Este sistema utiliza un modelo de 10 mil millones de parámetros para interpretar situaciones complejas, como el comportamiento de peatones o condiciones inusuales de tráfico.

Para validar su seguridad, Nvidia ha liberado herramientas de simulación y conjuntos de datos que permiten a otros desarrolladores poner a prueba sus propias aplicaciones en entornos virtuales de alta fidelidad antes de salir al asfalto real.